Komputery używają systemu binarnego, ponieważ 0 i 1 idealnie odwzorowują dwa stany elektryczne, zapewniając niezawodność.

- System binarny (dwójkowy) wykorzystuje tylko dwie cyfry: 0 i 1.

- Te cyfry odpowiadają fizycznym stanom elektrycznym, np. przepływ prądu (1) lub jego brak (0).

- Tranzystory, działające jak miniaturowe przełączniki, są podstawą tej dwustanowej logiki.

- Prostota dwustanowa jest znacznie bardziej niezawodna i odporna na błędy niż próba rozróżniania dziesięciu stanów.

- Wszystkie dane liczby, tekst, obrazy są kodowane jako ciągi zer i jedynek.

- Choć dla ludzi mniej intuicyjny, dla maszyn binarny jest najbardziej efektywnym sposobem przetwarzania informacji.

Dlaczego Twój komputer „myśli” w zerach i jedynkach, a nie jak człowiek?

Zastanawialiście się kiedyś, dlaczego komputer, tak zaawansowana maszyna, posługuje się tak prostym językiem, jakim są zera i jedynki? Dla nas, ludzi, system dziesiętny jest czymś absolutnie naturalnym. Myślimy w nim, liczymy, operujemy na dziesięciu cyfrach. Komputer jednak ma swój własny, zupełnie inny sposób „myślenia”, który, choć na pierwszy rzut oka wydaje się archaiczny, jest w rzeczywistości genialnie zoptymalizowany do jego fizycznej budowy. To nie kwestia inteligencji, a czystej pragmatyki i inżynierii.System dziesiętny: Nasz naturalny język liczb

System dziesiętny, z którym obcujemy na co dzień, jest dla nas niezwykle intuicyjny. Prawdopodobnie jego powszechność wynika z faktu, że mamy dziesięć palców u rąk, co od zarania dziejów ułatwiało nam liczenie. Używamy dziesięciu cyfr od 0 do 9 i na ich podstawie budujemy wszystkie liczby, nadając im wartość w zależności od pozycji. Jest to system, który doskonale sprawdza się w naszym codziennym życiu i myśleniu abstrakcyjnym. Jednak, jak się przekonamy, to, co dla nas jest wygodne, wcale nie musi być optymalne dla maszyny.

System binarny: Alfabet maszyn cyfrowych

W przeciwieństwie do nas, komputery posługują się systemem binarnym, czyli dwójkowym. Jak sama nazwa wskazuje, składa się on z zaledwie dwóch cyfr: 0 i 1. Ta ekstremalna prostota jest kluczem do zrozumienia działania każdej maszyny cyfrowej. Dlaczego? Ponieważ te dwa stany można niezwykle łatwo odwzorować fizycznie w układach elektronicznych. System binarny jest podstawą funkcjonowania współczesnych komputerów, ponieważ wykorzystuje tylko dwie cyfry: 0 i 1. Ta prostota jest kluczowa, gdyż te dwie wartości można łatwo odwzorować w fizycznym świecie elektroniki.

Fizyka w służbie informacji: Jak prąd elektryczny staje się danymi?

Aby w pełni zrozumieć, dlaczego komputery „mówią” w zerach i jedynkach, musimy zagłębić się nieco w świat fizyki i elektroniki. Abstrakcyjne cyfry 0 i 1 nie są dla komputera jedynie symbolami są one bezpośrednio związane z konkretnymi, mierzalnymi zjawiskami fizycznymi. To właśnie fizyka pozwala na przekształcenie tych prostych stanów w złożone dane, które widzimy na ekranie.

Dwa stany, czyli fundament wszystkiego: Włączony i wyłączony

Wyobraźmy sobie prosty włącznik światła. Może być on albo włączony, albo wyłączony nie ma stanu pośredniego. Dokładnie tak samo działa podstawowa logika w komputerze. Cyfry 0 i 1 są odwzorowywane w fizycznym świecie elektroniki w bardzo prosty sposób: stan „1” najczęściej reprezentuje przepływ prądu lub wysoki poziom napięcia, natomiast stan „0” oznacza brak prądu lub niski poziom napięcia. Ta dwustanowość jest niezwykle prosta do zrealizowania i, co najważniejsze, jednoznaczna. Nie ma tu miejsca na interpretację czy niepewność, co jest kluczowe dla niezawodności.

Tranzystor: Miniaturowy włącznik światła w sercu Twojego komputera

Podstawowym elementem budulcowym każdego procesora jest tranzystor. Można go sobie wyobrazić właśnie jako miniaturowy, elektroniczny włącznik światła. Tranzystor może być w jednym z dwóch stanów: włączony (przewodzi prąd) lub wyłączony (nie przewodzi prądu). Dzięki temu miliardy tranzystorów w układzie scalonym mogą reprezentować i przetwarzać ogromne ilości danych w postaci binarnej. To właśnie te maleńkie przełączniki, działające z niewyobrażalną prędkością, pozwalają na zapisywanie, odczytywanie i przetwarzanie wszystkich zer i jedynek, które składają się na oprogramowanie i dane, z których korzystamy.

Dlaczego 10 różnych stanów to zły pomysł? Niezawodność ponad wszystko

Można by zapytać: dlaczego nie zbudować komputera, który rozróżniałby dziesięć różnych poziomów napięcia, odpowiadających cyfrom od 0 do 9? Teoretycznie jest to możliwe, ale w praktyce okazuje się znacznie trudniejsze i, co najważniejsze, dużo mniej niezawodne. Rozróżnienie tylko dwóch stanów (np. 0V i 5V) jest znacznie łatwiejsze i mniej podatne na błędy spowodowane niewielkimi wahaniami napięcia, zakłóceniami elektromagnetycznymi czy niedoskonałościami produkcyjnymi. Gdybyśmy musieli rozróżniać dziesięć stanów, margines błędu byłby znacznie mniejszy, a system o wiele bardziej wrażliwy na jakiekolwiek zakłócenia. Próby budowy komputerów dziesiętnych, jak wczesny ENIAC, pokazały, że takie systemy są znacznie bardziej skomplikowane i kosztowne w realizacji, co ostatecznie doprowadziło do dominacji prostszego i bardziej niezawodnego systemu binarnego.

Od prostych bitów do kolorowych obrazów: Jak budować złożone informacje z zer i jedynek?

Skoro już wiemy, że komputer posługuje się tylko zerami i jedynkami, pojawia się naturalne pytanie: jak z tak prostych elementów można zbudować tak złożone informacje, jak zdjęcia, filmy, muzyka czy skomplikowane programy? Odpowiedź leży w odpowiednim grupowaniu i interpretacji tych podstawowych jednostek. To, co dla nas wydaje się magią, dla komputera jest logicznym procesem kodowania i dekodowania.

Bit i bajt: Podstawowe klocki cyfrowego świata

Najmniejszą jednostką informacji w świecie cyfrowym jest bit. Może on przyjąć tylko jedną z dwóch wartości: 0 lub 1. Bit jest jak pojedynczy atom informacji. Jednak, aby móc reprezentować coś bardziej złożonego, potrzebujemy większych „klocków”. Tutaj wkracza bajt grupa ośmiu bitów. Osiem bitów tworzy bajt, który jest podstawową jednostką pamięci i może reprezentować 256 różnych wartości (od 00000000 do 11111111 w systemie binarnym, co odpowiada liczbom od 0 do 255 w systemie dziesiętnym). To właśnie bajt jest podstawą do kodowania większości danych, z którymi pracuje komputer.

Kodowanie znaków (ASCII): Jak litera „A” staje się liczbą?

Weźmy na przykład tekst. Kiedy piszę literę „A” na klawiaturze, komputer nie widzi litery. Widzi ciąg zer i jedynek. Proces ten nazywamy kodowaniem znaków. Jednym z najbardziej znanych standardów jest ASCII (American Standard Code for Information Interchange). W systemie ASCII każdej literze, cyfrze, symbolowi czy znakowi specjalnemu przypisany jest unikalny ciąg binarny. Na przykład, duża litera „A” to w ASCII ciąg binarny 01000001 (co w systemie dziesiętnym odpowiada liczbie 65). W ten sposób tekst, który piszemy, jest zamieniany na zrozumiałe dla komputera zera i jedynki, które mogą być przechowywane, przesyłane i przetwarzane.

Liczby, kolory, dźwięki: Wszystko jest ciągiem binarnym

Ta sama zasada dotyczy wszystkich innych typów danych. Liczby są reprezentowane bezpośrednio w systemie binarnym. Kolory w obrazach są często kodowane jako kombinacje trzech bajtów (po jednym dla czerwonego, zielonego i niebieskiego), gdzie każdy bajt określa intensywność danego koloru. Dźwięk jest próbkowany, a każda próbka zamieniana na wartość binarną. Wideo to po prostu sekwencja obrazów i dźwięku. Kluczem jest to, że wszystkie dane w komputerze liczby, tekst, obrazy, dźwięki, wideo są ostatecznie kodowane jako ciągi zer i jedynek. Różnica polega jedynie na sposobie interpretacji tych ciągów przez oprogramowanie. To właśnie oprogramowanie „wie”, czy dany ciąg bitów to litera, liczba, czy fragment obrazu.

Matematyka dla maszyn: Czy komputery dodają i mnożą tak samo jak my?

Skoro komputery operują na zerach i jedynkach, to jak w ogóle wykonują skomplikowane obliczenia matematyczne? Czy dodają i mnożą tak samo jak my, tylko w innym systemie liczbowym? Odpowiedź brzmi: fundamentalnie inaczej, ale z tą samą precyzją, a nawet większą. Cała magia obliczeń komputerowych opiera się na prostych zasadach logiki, które są idealnie dopasowane do dwustanowej natury elektroniki.

Logika Boole’a w praktyce: Proste zasady skomplikowanych obliczeń

Podstawą wszystkich obliczeń komputerowych jest logika Boole’a, nazwana na cześć matematyka George’a Boole’a. Operuje ona na wartościach prawda/fałsz, które w świecie komputerów idealnie odpowiadają 1/0. Za pomocą zaledwie kilku prostych operacji logicznych, takich jak AND (i), OR (lub) oraz NOT (nie), komputery mogą wykonywać niezwykle złożone instrukcje i obliczenia. Na przykład, operacja AND zwraca „prawdę” (1) tylko wtedy, gdy oba jej wejścia są „prawdziwe” (1). Operacja OR zwraca „prawdę” (1), jeśli choć jedno z wejść jest „prawdziwe” (1). To właśnie te proste bramki logiczne, zbudowane z tranzystorów, są podstawą wszystkich skomplikowanych operacji, jakie wykonuje procesor.

Przykład: Jak komputer dodaje dwie liczby binarne?

Wyobraźmy sobie dodawanie dwóch liczb binarnych, na przykład 1 + 1. W systemie dziesiętnym to 2. W systemie binarnym 1 + 1 równa się 10 (czyli jeden i zero, gdzie 1 jest przeniesieniem do następnej pozycji, tak jak w dodawaniu dziesiętnym, gdy 5 + 5 = 10). Komputer wykonuje takie operacje za pomocą specjalnych układów, zwanych sumatorami, które wykorzystują bramki logiczne. Operacje arytmetyczne, takie jak dodawanie, odejmowanie czy mnożenie, są wykonywane przez procesor w systemie binarnym, według zasad podobnych do tych w systemie dziesiętnym, ale z wykorzystaniem tylko zer i jedynek. To, co dla nas jest skomplikowane do ręcznego wykonania, dla procesora jest serią błyskawicznych operacji logicznych na bitach.

Czy zawsze tak było i czy istnieją alternatywy?

Historia komputerów to fascynująca podróż, a binarność, choć dziś wszechobecna, nie zawsze była jedyną rozważaną opcją. Zastanówmy się, czy ta dominacja jest absolutna i czy przyszłość może przynieść nam zupełnie nowe sposoby przetwarzania informacji, wykraczające poza klasyczne zera i jedynki.

Krótka historia: Od maszyn dziesiętnych do dominacji binarności

W początkach informatyki, zanim system binarny stał się standardem, istniały próby budowy komputerów opartych na innych systemach liczbowych. Przykładem jest wspomniany już wcześniej ENIAC jeden z pierwszych elektronicznych komputerów ogólnego przeznaczenia. ENIAC operował na systemie dziesiętnym, wykorzystując dziesięć lamp elektronowych do reprezentowania każdej cyfry. Był to kolosalny, skomplikowany i niezwykle drogi w utrzymaniu potwór. Szybko okazało się, że prostota i niezawodność systemu binarnego, o których mówiłem, dają mu ogromną przewagę. Możliwość łatwego i jednoznacznego odwzorowania dwóch stanów fizycznych (prąd jest/nie ma prądu) sprawiła, że system binarny ostatecznie zdominował rozwój technologii komputerowej, stając się fundamentem całej współczesnej elektroniki cyfrowej.

Przeczytaj również: Jak włączyć lokalizację w iPhone? Pełna kontrola i prywatność.

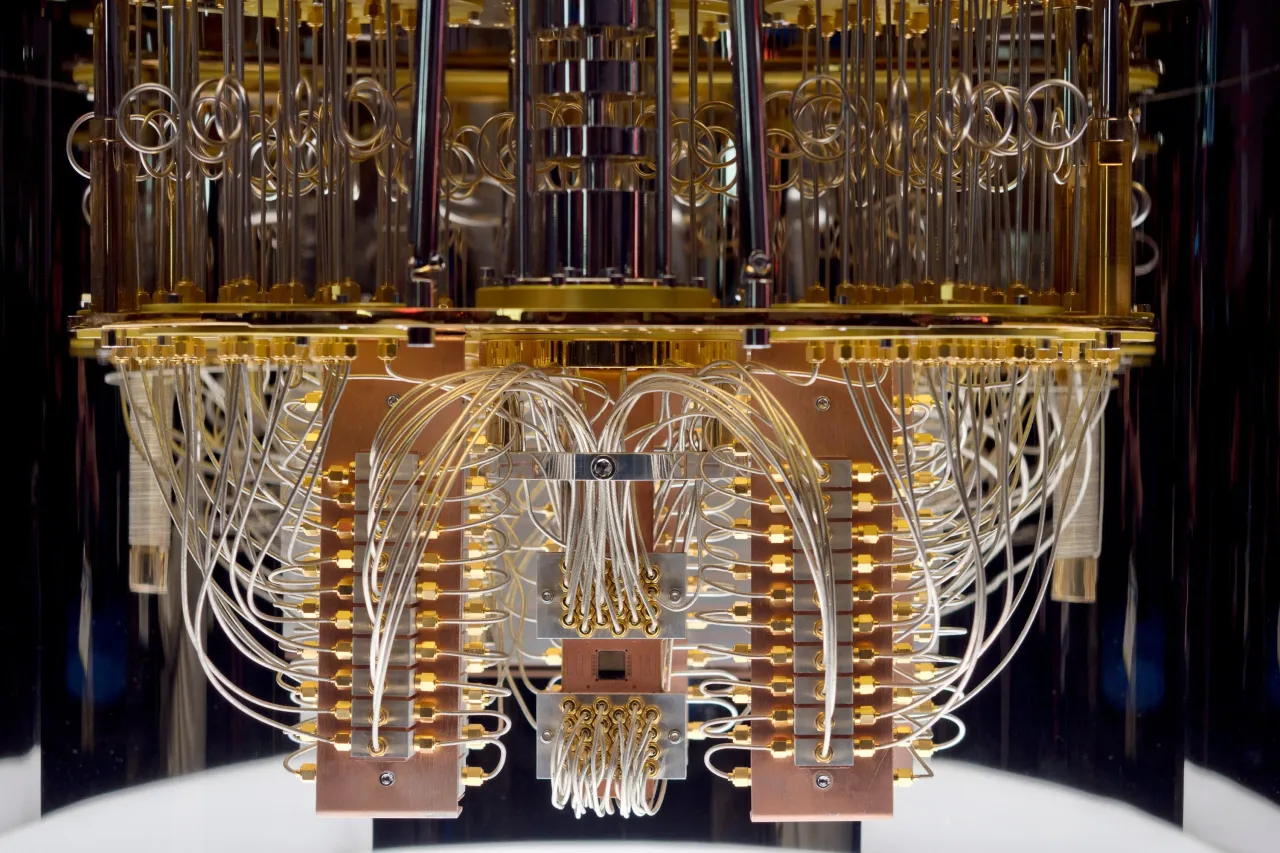

Spojrzenie w przyszłość: Komputery kwantowe i inne potencjalne kierunki

Czy binarność to jednak jedyna droga? Klasyczne komputery cyfrowe, z którymi mamy do czynienia na co dzień, opierają się na bitach, które mogą być albo 0, albo 1. Jednak nauka nie stoi w miejscu. Wspomnieć należy o komputerach kwantowych, które są obecnie w fazie intensywnych badań i rozwoju. Komputery kwantowe wykorzystują tzw. kubity (qubity), które, dzięki zjawiskom mechaniki kwantowej, mogą być jednocześnie w stanie 0, 1 lub w superpozycji obu tych stanów. To otwiera zupełnie nowe możliwości obliczeniowe, pozwalając na rozwiązywanie problemów, które są poza zasięgiem nawet najpotężniejszych superkomputerów klasycznych. Choć to wciąż odległa perspektywa i technologia na bardzo wczesnym etapie, pokazuje, że naukowcy poszukują nowych, jeszcze bardziej zaawansowanych sposobów przetwarzania informacji, które mogą wykraczać poza klasyczną binarność. To fascynujące, jak podstawy, które dziś omawiamy, mogą ewoluować w przyszłości.Podsumowanie: Dlaczego prostota systemu binarnego jest jego największą siłą?

Podsumowując naszą podróż w głąb cyfrowego świata, staje się jasne, że choć dla nas, ludzi, system binarny jest mniej intuicyjny i wymaga pewnego wysiłku, aby go zrozumieć, dla maszyn opartych na logice dwustanowej jest to najbardziej efektywny i naturalny sposób przetwarzania informacji. Kluczem do sukcesu i wszechobecności komputerów jest właśnie ta pozorna prostota.

Zera i jedynki idealnie odwzorowują fizyczne stany elektryczne obecność lub brak prądu, wysokie lub niskie napięcie. Dzięki temu tranzystory, działające jak miniaturowe przełączniki, mogą niezawodnie i z ogromną prędkością reprezentować i przetwarzać dane. Próby budowy komputerów opartych na systemie dziesiętnym okazały się znacznie bardziej skomplikowane i podatne na błędy, co tylko potwierdziło wyższość dwustanowej logiki.

Od pojedynczego bitu, przez bajty, aż po złożone struktury danych wszystko w komputerze jest ostatecznie sprowadzone do ciągów zer i jedynek. To właśnie ta prostota, niezawodność i łatwość implementacji fizycznej sprawiły, że system binarny stał się niezachwianym fundamentem całej współczesnej informatyki. To właśnie ta pozornie prosta koncepcja umożliwiła rozwój całej cyfrowej rewolucji, która ukształtowała świat, w którym dziś żyjemy.